Es una pregunta bastante común el preguntar si es mejor configurar el espacio de color AdobeRGB o sRGB, o por qué no usar ProPhoto o si no se podría usar ProPhoto para configurar el espacio de captura de la cámara.

La respuesta corta es que si disparas en RAW (cosa que deberías hacer si el objetivo es capturar la máxima calidad de imagen y tener la mayor información posible) eso es COMPLETAMENT IRRELEVANTE.

Sólo si disparas en jpeg eso determinará el espacio de color en que ése jpeg se ha generado (y para la miniatura interna del raw).

Los datos del raw serán exactamente los mismos uses uno u otro, es un simple metadato, al igual que ocurre con el balance de blancos.

La cámara no captura la imagen en un espacio de color ni lo transforma a ningún espacio de color cuando escribe el raw.

Ese suele ser un punto de confusión común.

Si hablamos de tomas captadas en raw, como es el caso, el espacio de color que selecciones en la cámara es absolutamente irrelevante.

Los datos de la cámara en el raw no están en ningún espacio de color, si acaso podemos entender que está en el suyo propio.

La cámara capta sólo intensidad lumínica (número de fotones incidentes en realidad) en cada pixel, si bien cada pixel tiene un filtro R G o B delante que altera qué fotones le llegan (de qué longitud de onda) y cuáles no.

El filtro rojo dejará pasar más de los cercanos al rojo, pero también deja pasar otras longitudes de onda cercanas pero con menos intensidad.

Así pues lo captado es el efecto de aplicar ese filtro que reduce unas longitudes de ona más que otras, al espectro de luz que llega (que indica la energía para cada longitud de onda).

Eso es lo que capta la cámara y convierte en un valor entre el nivel de negro y el punto blanco (un mínimo y un máximo habitualmente algo por encima de 0 y alrededor de 4096 el otro en las de 12 bits).

ESo no está en ningún espacio de color ni adobe ni prophoto ni nada.

De ahí se pasa al espacio CIE XYZ multiplicando por unos valores que conforman una matriz 3x3 (o bien usando un perfil de cámara si se ha perfilado).

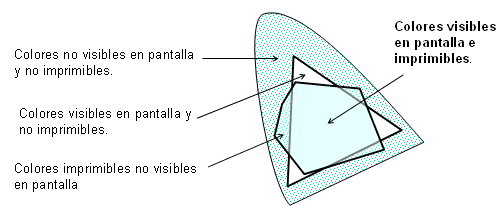

Ese espacio XYZ universal y que representa los colores tal como los ve el ser humano (a través de sus propios filtros con diferente respuesta a los de la cámara, los famososo conos) se pasa al espacio estandarizado, AdobeRGB o ProPhoto o el que se quiera que es en el que trabajamos.

De ahí al espacio de salida (la pantalla, usando el perfil de la pantalla, la impresora, usando el perfil de la impresora, o el espacio sRGB o el que queramos).

El color no existe en la realidad, no es algo físico, es psicológico, combinando la respuesta de nuestros ojos al estímulo del espectro a que se somenten con la interpretación que hace el cerebro.

Por eso insisto tanto en que no existe eso del color real ni tal como lo ha captado la cámara.

En el mundo físico sólo existen longitudes de onda y distribuciones de espectros diferente (cada luz, cada reflejo tiene una distribución espectral diferente).

La cámara sólo utiliza el espacio seleccionado para generar el jpeg, bien cuando disparamos en jpeg, bien cuando crea la miniatura que inserta en el raw.

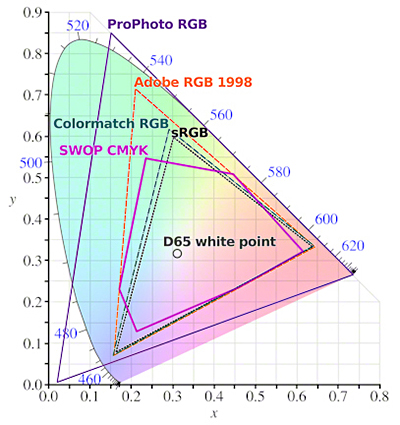

Te deja usar AdobeRGB o sRGB pero ninguna deja usar proPhoto.

No tendría sentido usar ProPhoto, es un espacio tan amplio que usar 8 bits (sólo 256 niveles) para representar los colores es demasiado poco, tendríamos mucho salto entre colores y muy poca gradación.

En cuanto tocaras algo aparecerían posterizaciones o cosas raras.

ProPhoto no ha de usarse si no es como mínimo en 16 bits.